-

प्रश्न :

क्या आपको लगता है, कि आर्टिफिशियल इंटेलिजेंस (AI) नैतिक सिद्धांतों से समझौता करता है? AI को जिम्मेदार निर्णय निर्माताओं में किस प्रकार बदला जा सकता है? (250 शब्द)

22 Feb, 2024 सामान्य अध्ययन पेपर 4 सैद्धांतिक प्रश्नउत्तर :

हल करने का दृष्टिकोण:

- आर्टिफिशियल इंटेलिजेंस (AI) का संक्षिप्त परिचय लिखिये।

- AI की नैतिक चुनौतियों का वर्णन कीजिये।

- उन तरीकों की व्याख्या कीजिये, जिनके माध्यम से AI को उत्तरदायी निर्णय निर्माताओं में परिवर्तित किया जा सकता है।

- तद्नुसार निष्कर्ष लिखिये।

परिचय:

आर्टिफिशियल इंटेलिजेंस (AI) एक कंप्यूटर या कंप्यूटर द्वारा नियंत्रित रोबोट की उन कार्यों को करने की क्षमता है, जो सामान्यतः मनुष्यों द्वारा किये जाते हैं क्योंकि उन्हें मानव बुद्धि और विवेक की आवश्यकता होती है। इन कार्यों में प्राकृतिक भाषा को समझना, पैटर्न को पहचानना, अनुभव से सीखना और निर्णय लेना शामिल है। AI सिस्टम का उद्देश्य तर्क, समस्या-समाधान, धारणा और सीखने जैसे मानव संज्ञानात्मक कार्यों की नकल करना है।

मुख्य भाग:

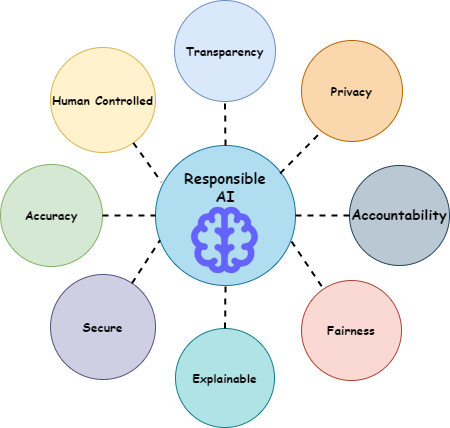

AI की कुछ प्रमुख नैतिक चुनौतियों में शामिल हैं:

- नौकरी विस्थापन और सामाजिक आर्थिक प्रभाव: AI द्वारा संचालित स्वचालन से कुछ उद्योगों में नौकरी विस्थापन हो सकता है। बेरोज़गारी और आय असमानता सहित परिणामी सामाजिक-आर्थिक प्रभाव, इन परिणामों को संबोधित करने में सरकारों और संगठनों की ज़िम्मेदारियों के बारे में नैतिक प्रश्न खड़ा करता है।

- गोपनीयता के अधिकार का उल्लंघन: AI सिस्टम का उपयोग इसमें शामिल व्यक्तियों की जानकारी या सहमति के बिना व्यक्तिगत डेटा एकत्र करने और उसका विश्लेषण करने के लिये किया जा सकता है। इससे सूचित सहमति और निजता के अधिकार के बारे में चिंताएँ उत्पन्न होती हैं।

- नैतिक तर्क के लिये संकट: जब परंपरागत रूप से मनुष्यों द्वारा लिये गए निर्णय एल्गोरिदम और AI को सौंप दिये जाते हैं, तो एक जोखिम होता है कि नैतिक तर्क की क्षमता से समझौता किया जा सकता है। इसका तात्पर्य यह है कि केवल AI पर निर्भर रहने से विचारशील नैतिक सोच में संलग्न होने की मानवीय क्षमता न्यूनतम हो सकती है।

- जवाबदेही और पारदर्शिता का अभाव: AI प्रणाली में कुछ त्रुटि होने पर ज़िम्मेदारी सौंपना मुश्किल हो सकता है, मूलतः जब इसमें जटिल एल्गोरिदम और निर्णय लेने की प्रक्रिया शामिल हो।

- कई AI प्रणालियों की आंतरिक कार्यप्रणाली प्रायः अपारदर्शी होती है, जिससे यह समझना मुश्किल हो जाता है कि निर्णय कैसे लिये जा रहे हैं। पारदर्शिता की कमी से उपयोगकर्त्ताओं के बीच अविश्वास और संदेह उत्पन्न हो सकता है।

- सुरक्षा: यदि AI सिस्टम में खराबी आती है, हैक किया जाता है, या दुर्भावनापूर्ण उद्देश्यों के लिये हेरफेर किया जाता है तो AI सिस्टम सुरक्षा के लिये जोखिम उत्पन्न कर सकता है। स्वायत्त शस्त्र प्रणालियों का विकास और तैनाती अंधाधुंध नुकसान की उनकी क्षमता और युद्ध में मानवीय जवाबदेही के क्षरण के बारे में चिंताएँ उत्पन्न करती है।

- रोबोटों के लिये नैतिकता को संहिताबद्ध करना: नैतिकता को रोबोटों या AI-संचालित सरकारी निर्णयों के लिये स्पष्ट नियमों में अनुवाद करने का प्रयास एक चुनौतीपूर्ण कार्य के रूप में उज़ागर किया गया है। मानवीय नैतिकताएँ बहुत जटिल हैं और इन जटिल विचारों को कंप्यूटर निर्देशों में फिट करना मुश्किल है।

कुछ तरीके जिनके माध्यम से AI को उत्तरदायी निर्णय निर्माताओं में परिवर्तित किया जा सकता है:

- नैतिक डिजाइन सिद्धांत: AI सिस्टम के डिजाइन चरण में नैतिक विचारों को शामिल करना आवश्यक है। जेम्स मूर (डार्टमाउथ कॉलेज के प्रोफेसर) ने नैतिकता से संबंधित यांत्रिक अभिकर्त्ताओं को चार समूहों में वर्गीकृत किया है:

- नैतिक प्रभाव एजेंट: ये मशीनें, रोबोट जॉकी के समान, स्वयं नैतिक विकल्प का निर्माण नहीं करती हैं, लेकिन उनके कार्यों का नैतिक प्रभाव पड़ता है। उदाहरण के लिये, वे किसी काम करने के तरीके को परिवर्तित कर सकते हैं।

- निहित नैतिक अभिकर्त्ता: इन मशीनों में विमानों में ऑटोपायलट की तरह अंतर्निहित सुरक्षा या नैतिक नियम होते हैं। वे सक्रिय रूप से यह तय किये बिना कि नैतिक क्या है, निर्धारित नियमों का पालन करते हैं।

- स्पष्ट नैतिक अभिकर्त्ता: ये निश्चित नियमों से परे जाते हैं। वे विकल्पों के नैतिक मूल्य का पता लगाने के लिये विशिष्ट तरीकों का उपयोग करते हैं। उदाहरण के लिये, ऐसी प्रणालियाँ जो धन के निवेश को सामाजिक उत्तरदायित्व के साथ संतुलित करती हैं।

- पूर्ण नैतिक अभिकर्त्ता: ये मशीनें नैतिक निर्णय ले सकती हैं और समझा सकती हैं। अच्छी नैतिक समझ वाले वयस्क और उन्नत AI इस श्रेणी में आते हैं।

- निष्पक्षता और पूर्वाग्रह शमन: निर्णय लेने में निष्पक्षता सुनिश्चित करने के लिये AI एल्गोरिदम में पूर्वाग्रह का पता लगाने और उसे कम करने के लिये तकनीकों को नियोजित करना महत्त्वपूर्ण है। इसमें पूर्वाग्रह को दूर करने के लिये डेटा प्रीप्रोसेसिंग, एल्गोरिथम निष्पक्षता बाधाएँ और निष्पक्षता-जागरूक शिक्षण एल्गोरिदम जैसी तकनीकें शामिल हैं।

- स्पष्टीकरण और पारदर्शिता: अपने निर्णयों के लिये स्पष्टीकरण प्रदान करके AI सिस्टम की पारदर्शिता बढ़ाने से उपयोगकर्त्ताओं को यह समझने में मदद मिलती है कि AI एल्गोरिदम कैसे काम करते हैं और विश्वास स्थापित करते हैं।

- जवाबदेही तंत्र: AI सिस्टम को उनके निर्णयों और कार्यों के लिये जवाबदेह बनाने के लिये तंत्र स्थापित करना आवश्यक है। इसमें निर्णय लेने की प्रक्रिया को ट्रैक करने के लिये ट्रेसेबिलिटी उपाय, AI सिस्टम प्रदर्शन का आकलन करने के लिये ऑडिटेबिलिटी सुविधाएँ और त्रुटियों के मामले में सहारा या निवारण के लिये तंत्र शामिल हैं।

- नियामक और शासन ढाँचे: ज़िम्मेदार AI सुनिश्चित करने के लिये AI सिस्टम के विकास, तैनाती और उपयोग की निगरानी के लिये मज़बूत नियामक ढाँचे और शासन तंत्र विकसित करना महत्त्वपूर्ण है। इसमें कानूनी मानक, उद्योग दिशानिर्देश, प्रमाणन कार्यक्रम और AI अनुप्रयोगों की निगरानी के लिये नियुक्त निरीक्षण निकाय शामिल हैं।

- नैतिकता प्रशिक्षण और शिक्षा: डेवलपर्स, डेटा वैज्ञानिकों और अन्य हितधारकों के लिये AI नैतिकता पर शिक्षा और प्रशिक्षण कार्यक्रम प्रदान करना नैतिक जागरूकता और ज़िम्मेदार AI प्रथाओं को बढ़ावा देने के लिये आवश्यक है। इसमें नैतिक AI पाठ्यक्रम विकास, पेशेवर प्रमाणन कार्यक्रम और AI विकास में नैतिक निर्णय लेने पर कार्यशालाएँ शामिल हैं।

निष्कर्ष:

AI विकास और तैनाती में नैतिक विचारों को प्राथमिकता देकर, हम सभी के लिये अधिक समावेशी, न्यायसंगत और लाभकारी भविष्य बनाने के लिये AI प्रौद्योगिकियों की क्षमता का उपयोग कर सकते हैं।